Drawable

jedec

软件

USB转JTAG

kudu读写流程

Java并发

RHCE

批量下载图片的插件

下载视频方法

安全框架

快捷键替换

格式

图搜索算法

readelf

log4j

Launcher

docker 搭建es

信号

未定义权限

最佳实践

Reformer

2024/9/2 5:34:52LLM - 大语言模型的自注意力(Self-Attention)机制基础 概述

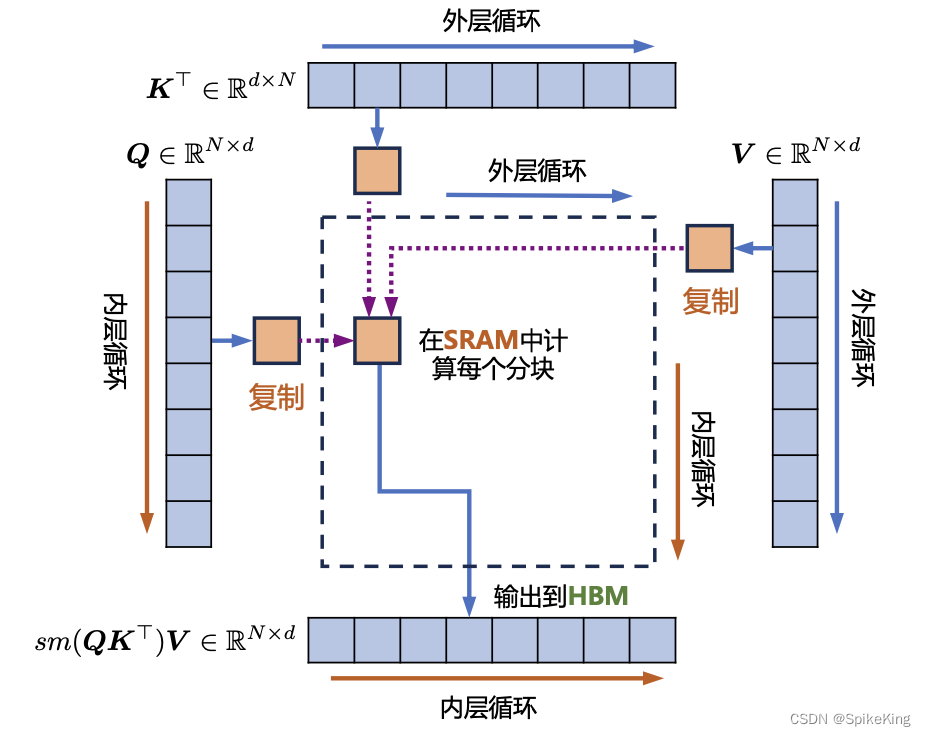

欢迎关注我的CSDN:https://spike.blog.csdn.net/ 本文地址:https://blog.csdn.net/caroline_wendy/article/details/136623432 注意力(Attention)机制是大型语言模型中的一个重要组成部分,帮助模型决定在处理信息时,所应该关注的部…

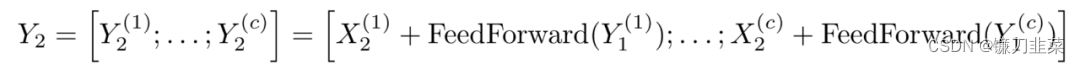

【NLP】手把手使用PyTorch实现Transformer以及Transformer-XL

手把手使用PyTorch实现Transformer以及Transformer-XL Abstract of Attention is all you need使用PyTorch实现Transformer1. 构建Encoder-Decoder模型1.1 导入依赖库1.2 创建Encoder-Decoder类1.3 创建Generator类 2. 构建Encoder2.1 定义复制模块的函数2.2 创建Encoder2.3 构…