Transformer网络,自2017年由谷歌提出以来,因其在机器翻译上的卓越表现迅速在NLP领域崭露头角,吸引了广泛关注。尽管其复杂的结构对初学者而言可能令人望而生畏,但其背后的工作原理却充满了精彩之处。

Transformer的核心在于其编码(encode)和解码(decode)过程,这类似于变形金刚的变形机制。具体来说,Transformer通过将输入内容拆解并重组来实现语言的转换。这个过程涉及到了多个编码器和解码器的串联组合,通常采用六层结构,意味着每次完整的转换需经历12步操作。

每个编码器单元都包含了自注意力(self-attention)机制和前馈网络两个核心模块。自注意力机制通过加权求和来实现对上下文的全局理解,类似于变形金刚拆解时的对照表,标记出各部分的权重和相互关系。前馈网络则负责根据这些权重调整数据状态。

值得一提的是,在编码器和解码器之间,还存在一种称为编码器-解码器注意力(encoder-decoder attention)的机制。它在重组时不仅考虑当前信息,还会参考编码过程中的整体上下文信息。在机器翻译中,这意味着解码时的每个词不仅关注已翻译内容,还需考虑编码器中的上下文信息。

此外,Transformer引入了多头注意力(multi-head attention)机制,进一步增强了模型处理复杂信息的能力,类似于变形金刚的多个部件分别进行变形。

让我们深入探索Transformer网络中数据的流动方式。首先,算法将单词转换为向量形式,并嵌入位置信息,统一成特定长度,例如512位。这些向量作为输入被送入编码器,接着通过自注意力(self-attention)机制和前馈网络传递到下一个编码器。

在这个流程中,自注意力机制像是重要的零件,通过权重揭示单词间的相互关系,并将上下文信息嵌入其中。具体来说,每个输入向量首先嵌入位置信息,然后分别与三个经过训练的向量Q、K和V相乘。利用每个单词的Q向量与所有单词的K向量相乘,得到的结果就是注意力权重。接下来,这些权重通过softmax函数进行归一化,以过滤掉不相关的单词。最后,乘以V向量并进行加权求和,就生成了输出向量Z。

在这个过程中,Q、K、V三个向量的作用类似于数据库操作中的查询(query)、键(key)和值(value),因此它们被赋予了这样的名称。这些步骤共同构成了Transformer中的核心机制,使得网络能够高效地处理和转换数据。

在理解Transformer网络的复杂细节时,我们不必一开始就深究每一个部分。重要的是要明白,整个过程通过一系列矩阵操作实现了单词间的权重计算。用矩阵的语言来描述,这个过程变得更为简洁和清晰。

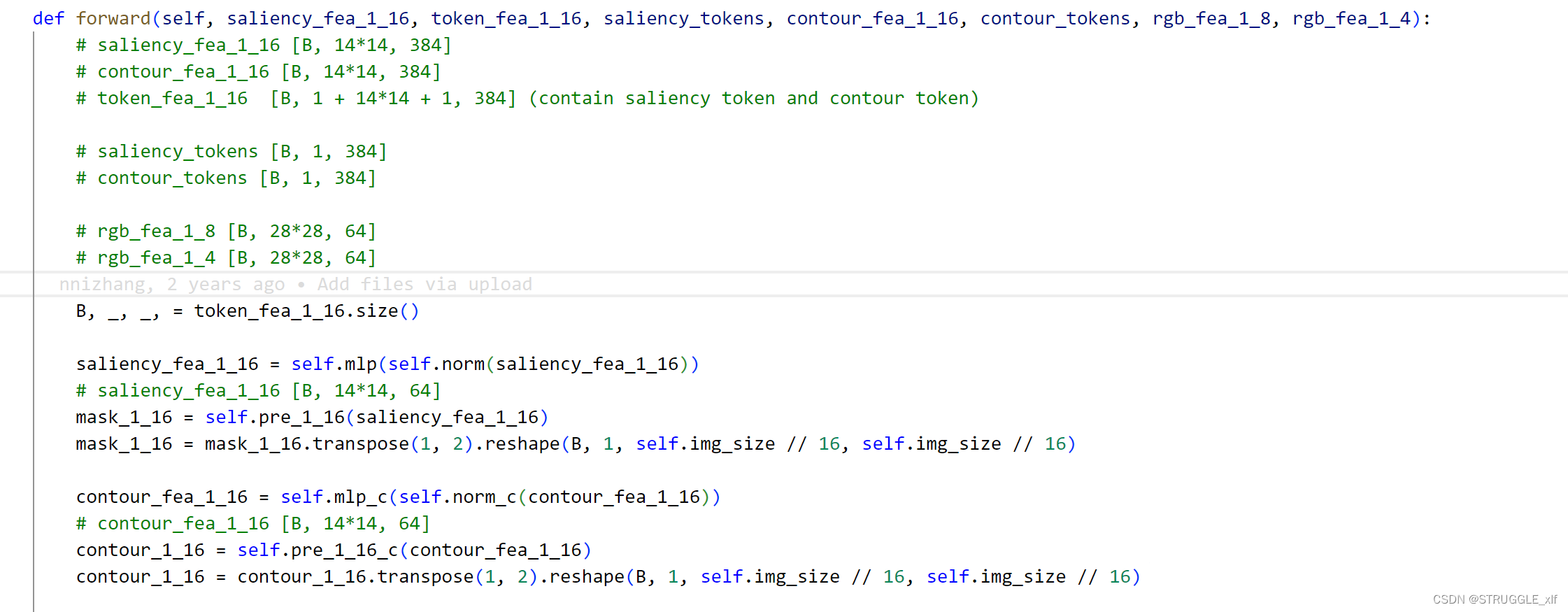

首先,输入单词的矩阵X与三个训练好的权重矩阵相乘,产生了Q、K、V矩阵。接下来,这些矩阵被用于计算自注意力机制。在自注意力机制中,尽管输出矩阵Z的维度与输入矩阵X相同,但它编码了其他单词的上下文信息,使得每个单词都融入了周围的环境信息。

在多头注意力(multi-head attention)部分,系统采用了不同的权重矩阵,对Q、K、V进行了八次独立的计算。这可能让人疑惑,为什么需要进行这么多次重复的操作?其实,这样做的主要目的是为了减少Q、K、V初始值的影响,提高模型的健壮性和准确性。这就好比将一个任务分配给八个人来完成,即使其中某个环节出现问题,也不会对整体结果产生太大影响。

最终,这些计算结果被汇总并求得一个加权平均值,形成了最后的输出矩阵Z。将这些步骤综合起来,我们就得到了Transformer网络的整体结构。这种结构能够有效地处理和转换数据,确保单词之间的关联性得到充分体现。

讲到这里,你应该对Transformer网络的核心部分——自注意力(self-attention)机制有了一定的理解。它的本质在于通过一系列精巧的操作来计算单词之间的关联权重。确实,Transformer网络的细节非常多,一时间难以记住所有内容,但我们可以逐步梳理。

Transformer的工作过程类似于变形金刚的变形过程,涵盖了编码(编码器)和解码(解码器)两个主要部分。首先,它将信息打散成零件,然后再重新组装起来。这个过程分为六个阶段,每个阶段又细分为八个部分,每部分都有自己独特的“变形说明书”,记录了各个零件的权重和它们之间的相互关系。这些“说明书”实际上就是自注意力机制,用于指导数据的处理和转换。

看到网上那些复杂的Transformer介绍,你可能会好奇,开发者当初是如何想出这样一种创新的结构的。其实,这种创造性的思维可能与我们小时候玩变形金刚的过程相似。或许,开发者的灵感就来源于这种儿时的游戏体验。正是这样的创新思维,让Transformer网络成为了自然语言处理领域的一大突破。

让我们来深入了解Transformer网络中各个模块如何协同工作。首先,编码器处理输入序列,将其输出转化为注意力向量K和V,这些可以被看作是我们所说的“零件拆解说明书”。进入解码器阶段,系统不仅查看自身的拆解说明书,还会考虑在拆分过程中与其他零件的相互关系。每个阶段都会组装出一个零件,重复这个过程直至完成整个序列的重建。

那么,解码器输出的向量是如何转换成一个单词的呢?这就是线性层和softmax层发挥作用的环节。线性层是一个简单的全连接网络,它将解码器的输出投影成一个维度很长的一维向量。这个向量包含了所有可能出现的单词,数量可能达到20,000个。接着,softmax层对这些单词进行进一步的归一化,选出概率最高的单词作为最终输出。这样的过程使得Transformer网络的运作更加直观易懂。

至于Transformer网络的训练,依然采用梯度下降算法。这个过程通过减少预测值和实际值之间的误差,并通过反向传播调整模型参数的权重,从而实现有效的学习和优化。通过这种方式,Transformer能够不断学习和适应,以提高其整体性能和准确度。